Die Forderung nach lokal ausgeführter KI wird lauter – sei es aus Gründen des Datenschutzes, der Latenz oder der Unabhängigkeit von Cloud-Diensten. Doch besonders bei Large Language Models (LLMs) stoßen herkömmliche Notebooks schnell an Grenzen: Hoher Stromverbrauch, rechenintensive Workloads und die Abhängigkeit von leistungsstarken GPUs machen lokales Deployment zur Herausforderung. Hier könnte ein neuer Ansatz von Qualcomm und der Entwickler-Community von Anything LLM die Spielregeln ändern – ermöglicht durch NPUs in Snapdragon-SoCs und Windows on Arm.

Anything LLM: Vom Cloud-Modell zum lokalen Begleiter

Anything LLM ist ein vielseitiges Open-Source-Toolkit, das Entwicklern die Integration von LLMs wie GPT-3 oder Llama in eigene Anwendungen erlaubt. Bisher liefen solche Modelle entweder in der Cloud oder erforderten leistungsstarke GPUs vor Ort – beides für mobile Nutzer oder Entwickler mit Fokus auf Energieeffizienz kaum ideal. Doch durch die Portierung von Anything LLM auf Windows-on-Arm-Geräte mit Snapdragon-SoCs zeigt Qualcomm, wie dedizierte KI-Hardware (NPUs) diese Lücke schließen kann.

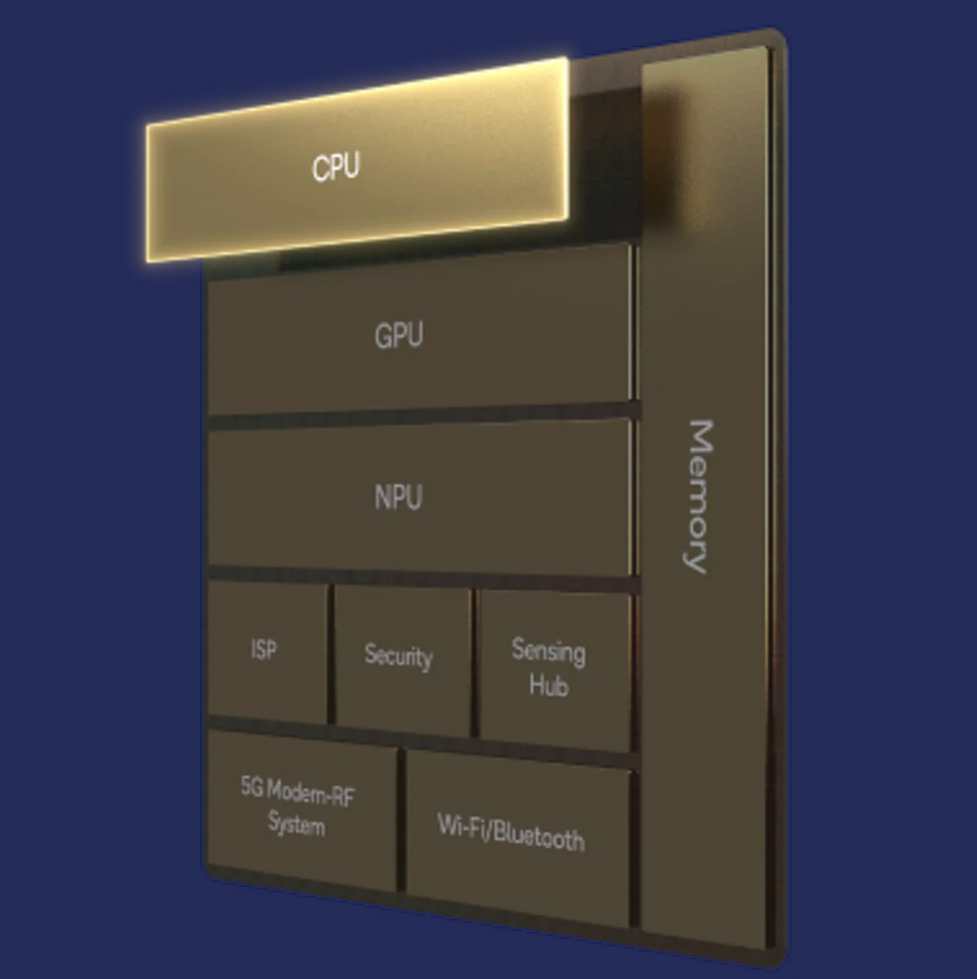

Snapdragon NPUs: Energieeffizienz trifft auf KI-Processing

Im Kern der Demo steht die Snapdragon-8cx-Gen-3-Plattform, deren Neural Processing Unit (NPU) speziell für KI-Workloads optimiert ist. Laut Qualcomm ermöglichte die Nutzung des Qualcomm AI Stack und des SNPE SDK (Snapdragon Neural Processing Engine) eine schnelle Portierung von Anything LLM. Die NPU übernimmt dabei die Inferenz der LLMs, entlastet die CPU/GPU und reduziert den Stromverbrauch signifikant – ein entscheidender Vorteil für Notebooks, die auf Akkulaufzeit und geräuschlosen Betrieb ausgelegt sind.

Praktische Vorteile

- Latenz: Die NPU-beschleunigte Inferenz soll Antwortzeiten im Sekundenbereich ermöglichen, selbst bei moderat großen Modellen.

- Effizienz: Im Vergleich zur CPU-basierten Ausführung soll der Stromverbrauch um bis zu 40% sinken.

- Entwicklerfreundlichkeit: Durch Tools wie das Windows ML NPU-Plugin können Entwickler vorhandene ONNX-Modelle mit minimalem Aufwand für die NPU optimieren.

Herausforderungen und Grenzen

Auch wenn die Demo beeindruckt, bleiben Fragen offen: Aktuell unterstützen die Snapdragon-NPUs primär INT8-Präzision, was bei sehr großen LLMs mit hoher Komplexität zu Qualitätseinbußen führen kann. Zudem ist die Modellgröße durch den begrenzten Arbeitsspeicher (typisch 16–32 GB in aktuellen Arm-Notebooks) eingeschränkt. Für GPT-4 oder vergleichbare Modelle bleibt die Cloud (vorerst) unumgänglich.

Ein Schritt nach vorn für Windows on Arm

Die Portierung von Anything LLM zeigt, wie NPUs in mobilen SoCs das Ökosystem für lokale KI-Anwendungen bereichern können. Für Entwickler eröffnet sich dadurch die Chance, ressourcenschonende KI-Tools zu entwickeln – etwa für Echtzeit-Übersetzungen, lokale Datensynthese oder persönliche Assistenten. Auch Microsoft treibt die Integration voran: Mit DirectML und optimierten Treibern soll die NPU-Unterstützung in Windows zukünftig nahtloser werden.

Fazit: Lokale KI als Nische – mit Potenzial

Noch sind Windows-on-Arm-Geräte mit Snapdragon-Chips ein Nischenmarkt. Doch Projekte wie Anything LLM demonstrieren, dass die Kombination aus NPUs, energieeffizienten SoCs und Windows ein zukunftsträchtiges Trio bilden könnte – besonders für Nutzer, die unterwegs auf Cloud-unabhängige KI setzen möchten. Ob sich daraus ein breiter Trend entwickelt, hängt auch davon ab, wie schnell die Hardware größere Modelle handhaben kann. Bis dahin bleibt die Devise: Kleine Schritte, großer Effekt.

Hinweis: Die genannten Leistungsdaten basieren auf Qualcomms Marketing-Materialien. Unabhängige Benchmarks stehen noch aus.

Was denkt ihr? Können NPUs in Mobilgeräten langfristig mit dedizierten GPUs mithalten – oder bleibt lokale KI eine Ergänzung zur Cloud? Diskutiert mit uns im Kommentarbereich!

Download: AnythingLLM für Windows on Arm

Quellen: Qualcomm Blog;